书籍GrokkingDRL 第一章的学习笔记https://www.manning.com/books/grokking-deep-reinforcement-learningwww.manning.com/books/grokking-deep-reinforcement-learning

.Grokking Deep Reinforcement Learning.1. 什么是深度强化学习1.1 人工智能(AI)人工智能(AI)是计算机科学的一个分支,研究能够展现出智能的计算机程序 “智能”似乎是一个广义的术语,但传统上,任何显示认知能力的软件,如感知,搜索,计划和学习,都被视为AI。

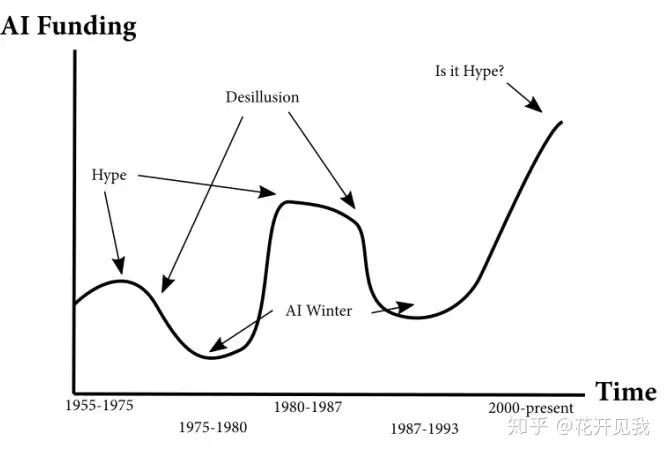

这是一些人工智能应用的例子:•百度地图高德地图的推荐路线•各种手机助手应用程序的语音识别 •淘宝京东等的推荐商品 •无人驾驶汽车人工智能领域多年来的发展一直延续着这种模式:研究取得进展,高估并过度承诺加大投入,结果不如预期,减少或完全切断研究经费。

下面是近年来ai投入的变化图

人工智能最近的炒作可能会让我们担心另一个寒冬, 现在的人工智能热潮和过去还是有一些不同现在世界上最强大的公司对人工智能研究投入最大谷歌,Facebook,微软,亚马逊和苹果等公司自成立以来就投资于人工智能研究,并且依靠人工智能赚取了大量的利润。

他们庞大而稳定的投资为当前的人工智能研究步伐创造了完美的环境目前的研究人员拥有最好的计算能力和大量的研究数据,顶尖研究人员团队正在同一地点同时解决同样的问题目前的人工智能研究已变得更加稳定和高效我们一直在目睹一个人工智能的成功,并且不太可能停止。

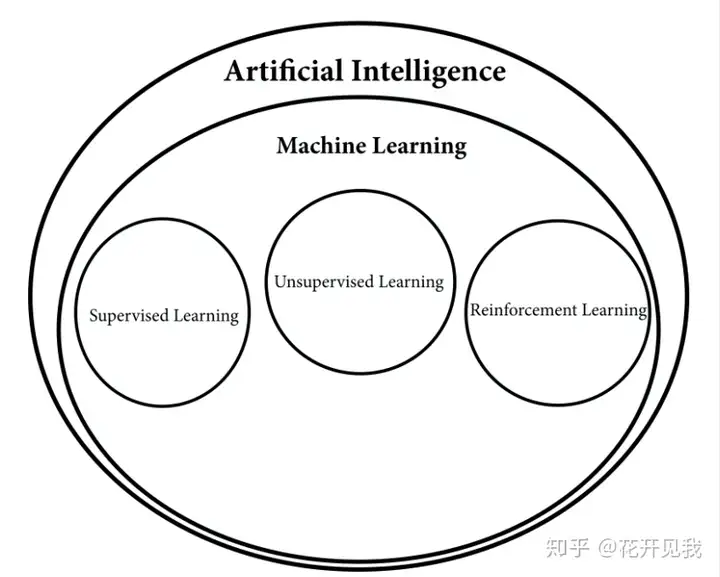

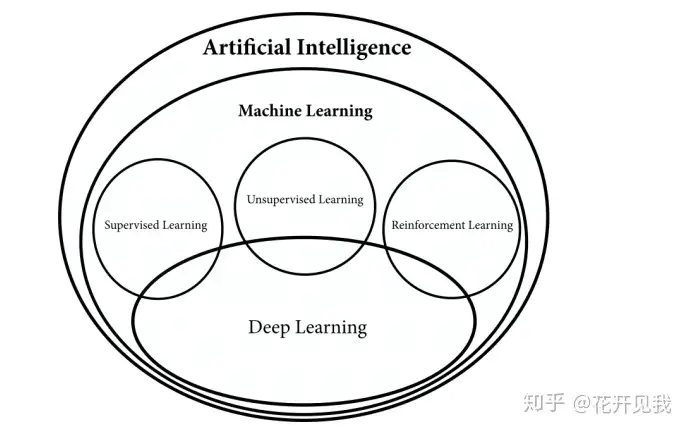

1.2 机器学习机器学习的主要分支

机器学习主要分支有监督(Supervised Learning) , 非监督(UnsupervisedLearning), 强化学习(Reinforcement Learning)您可能熟悉监督学习,这是最受研究和众所周知的机器学习问题。

它的基本问题是:当给出一组示例对时,如何自动构建将某些输入映射到某个输出的函数?在这些方面听起来很简单,但问题包括计算机最近才开始处理一些成功的许多棘手问题有很多监督学习问题的例子,包括:文本分类:这封电子邮件是否是垃圾邮件?

图像分类和对象位置:此图像是否包含猫,狗或其他图片? 回归问题:房价预测, 天气预报中的降雨量温度湿度等的预测? 这些问题可能看起来不同,但它们有着相同的想法:我们有许多输入和所需输出的例子,我们想学习如何为未来的,目前看不见的输入生成输出。

这个名称来自于我们从已知答案中学习的事实,这些答案是从一些主管那里获得的,该主管为我们提供了那些标记的例子 另一个类别就是无监督学习,它假定没有监督,没有分配给我们的数据的已知标签主要目标是学习手头数据集的一些隐藏结构。

这种学习方法的一个常见例子是数据聚类当我们的算法试图将数据项组合成一组聚类时,就会发生这种情况,聚类可以揭示数据中的关系 另一种越来越受欢迎的无监督学习方法是Generative Adversarial Networks(GANs)。

当我们有两个竞争神经网络时,他们中的第一个试图生成假数据以欺骗第二个网络,而另一个试图区分人工生成的数据和从我们的数据集中采样的数据随着时间的推移,他们通过捕获数据集的细微特定模式,在他们的任务中变得越来越熟练。

强化学习是第三阵营,介于完全监督和完全缺乏预定义标签之间一方面,它使用许多成熟的监督学习方法,例如用于函数逼近的深度神经网络,随机梯度下降和反向传播,以学习数据表示另一方面,它通常以不同的方式应用它们。

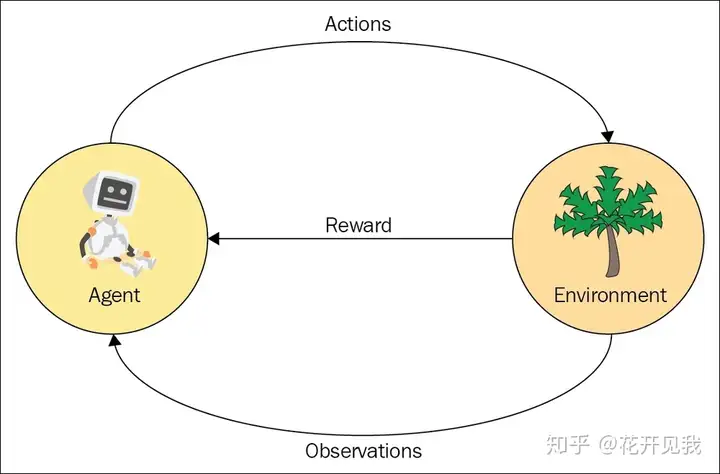

1.3 强化学习介绍(RL)数学,工程学,心理学,经济学,神经科学,计算机科学等领域都对最佳行动选择问题感兴趣 - 如何为复杂系统制定行动政策?强化学习是这种需求的产物 RL可以被认为是计算行为主义行为主义是一种研究人类和动物行为的心理学方法,并指出与环境的相互作用是所有行为的源泉。

环境试图强化或阻止某些行为,最终决定在特定情况下人和动物的那些行为最适宜环境 RL与行为主义之间没有正式的联系,但人类和动物的行为可以帮助我们直接理解强化学习我们以训练猫咪使用猫砂盆为例介绍强化. 当猫在猫砂盆排便你给他一个奖励比如给他喜欢吃的东西. 强化学习是代理 和系统(称为环境)之间的交互循环。

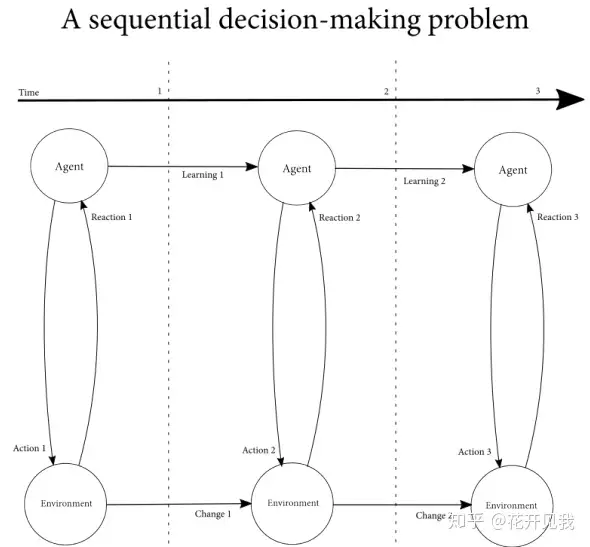

在猫训练的例子中,你的猫是一个代理,你是它的环境循环开始于代理观察环境. 代理对得到的观察进行处理比如记忆学习.然后,代理会根据环境采取行动, 而行动会对环境产生影响.通常,该操作以两种不同的方式影响环境:。

首先,代理可能观察得到也可能观察不到环境的变化, 这种环境内部变化,可能会产生延迟后果,只会在未来的交互中出现其次,代理根据其观察到的环境变化, 做出反应环境的变化或者响应可能是最后一个行为的直接后果,但它也可能与某些早期的行动有关。

整个循环: 观察,处理,行动,来自环境的响应 - 然后重复。

1.4 强化学习的特点强化学习有3个值得注意的特点首先,强化学习可以看成一个连续决策过程

决策可能不会仅影响当时的反馈信号,还可能会影响所有可能的未来反馈信号. 能够影响环境使决策变得复杂,因为不能简单地选择对当前系统状态具有最高直接回报的行动;相反,我们的决策也必须考虑到我们将带来的环境变化.

例如:砍伐森林是一个连续决策问题尽管采伐作业为我们提供了我们非常需要的木材和纸制品,但去除树木也会以可能有害的方式影响环境,甚至对我们自己也是如此因此,我们不能简单地只是选择最大化我们的直接利益的行动,必须考虑行动对环境的影响,以及环境的改变对我们的未来的影响。

RL的第二个显着特征是使用评估反馈,而不是监督监督学习中使用的监督反馈简单明了比如简单的类别好或者坏, 一星到五星, 价格多少元.而评估反馈就没怎么简单了, 你必须先收集数据进行比较, 还有很多你看不到的数据会影响你现在收集到的数据的含义.。

RL第三个明显的特征是它依赖于对环境的详尽抽样在“表格式”强化学习中,您通常将所有可能的环境状态和动作组合放在表格上,然后模拟与环境的数百万次交互,从而暴露您在该环境中所有可能遇到的情况另大多数强化学习理论仅存在于详尽的抽样案例中,但强化学习和监督学习的结合使我们能够建立能够解决复杂问题的强化学习代理,其中详尽的抽样是低效甚至是不可能的。

1.5 深度学习深度学习可以提高机器学习所有的类别

人工神经网络(NN)已存在数十年深度学习的特殊之处在于,近年来,我们已经突破了三层的硬限制,达到两位数以上层数的网络.用于训练NN的最流行的算法是反向传播,并且它通过从一个层向后传播梯度的部分计算来工作,以计算前一层的梯度。

它从输出到输入工作然而,从输入层到输出层,从另一个角度考虑NN可以说更直观另一方面,比如神经网络的第一层学习原始几何特征,例如点,线和曲线下一层学习基本的几何图形,如圆形,正方形和其他形状下一层学习对其训练过的动物更具特异性的特征,例如耳朵,鼻子,眼睛等。

顶部的最后一层将学习如何对不同的动物进行分类由于我们以前的3层限制,我们可以执行的抽象数量并不是那么多相反,专家必须手工创建相关的抽象,因此他们可以在这些特征向量上训练一个简单的神经网络模型然而,在2006年,一组加拿大研究人员引入了能够突破这一限制的算法,并将这些新技术应用于识别任务 - 首先是手写数字,后来是语音。

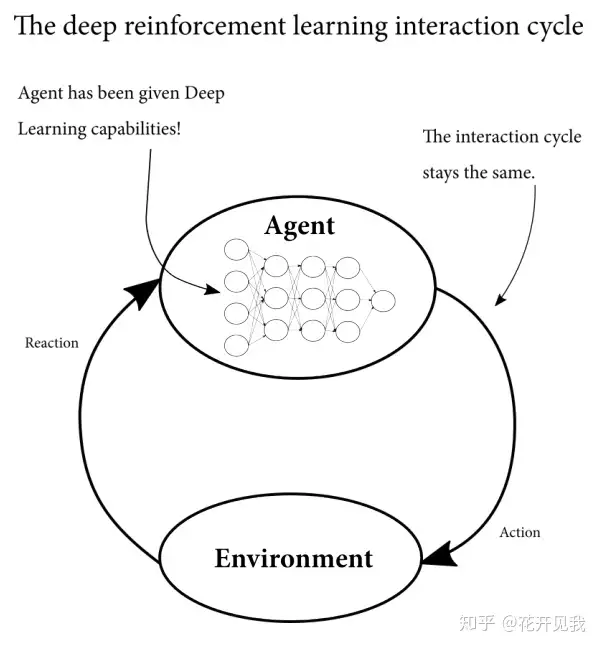

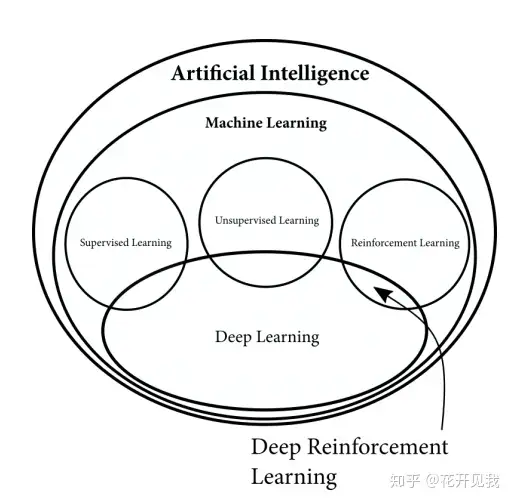

他们取得的成果震惊了机器学习界,并彻底改变了人工智能领域因此,深度学习社区一直在影响ML的每个分支,并影响工业和工业,并创造当前的研究状态1.6 深度强化学习

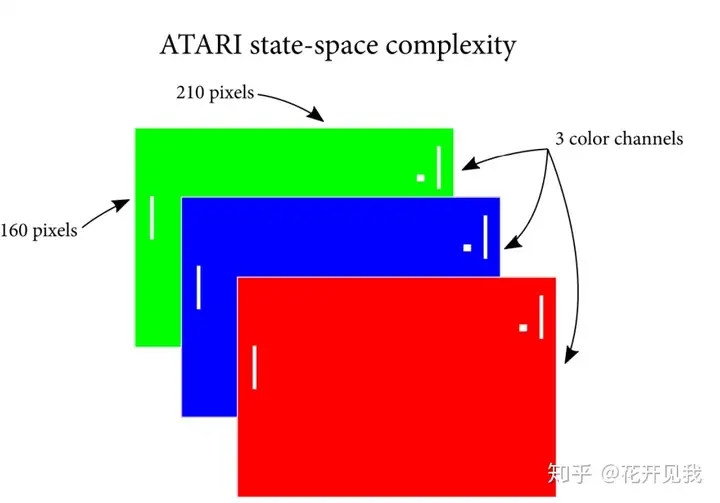

假设,你想训练一个代理玩一个雅达利游戏ATARI游戏, 输出高维数据;图像为210 x 160像素,3通道视频为, 每秒60次尽管如此,这种表示并不包括动作为此,我们必须使用最后几帧来确定球的速度等

那是一个非常大的状态空间此外,机器人控制问题具有连续的状态空间,像围棋这样的游戏状态空间比宇宙中的原子数还多当然,即使您可以设计一种方法来存储具有在这些环境中可能遇到的所有值的表,但以这种方式学习也是非常低效的。

相反,我们应该利用泛化技术来找到近似解鉴于对状态空间进行详尽的采样是非常困难的,有时甚至是不可能的,我们需要转向机器学习的其他领域中的函数逼近方法创建可以学习玩雅达利的DRL代理的一种方法是创建深度学习模型,卷积神经网络,用于将视频流的一组4个连续图像映射到给定状态的游戏动作中的每个可能动作。

首先,代理选择随机移动,在过了几局之后代理知道学会怎么玩这个游戏.监督方法不必从所有可能的数据中学习,相反,任务是从少数样本中学习,然后推广到看不见的样本虽然不是深度学习和强化学习相结合的唯一方法,深度强化学习(DRL)最常用的方法是使用深度学习来近似大型强化学习问题的状态空间。

通过这样做,我们可以解决之前无法解决的RL问题大多数时候,深度学习层将用于改善代理的感知,但这不是我们可以使用深度学习来改进强化学习代理的唯一方式。